ComfyUI

安装部署

官方没有没有提供docker镜像,三方向镜像的确有不少,大致看了几个,要么不怎么更新,要么集成了一些自己不需要的功能和模型。所以用nvcr.io/nvidia/cuda:12.8.1-cudnn-devel-ubuntu22.04镜像手动安装,是个不错的选择。

启动镜像:

docker run --gpus '"device=3"' -d --rm -p 3001:3001 --name comfyui \

-v /DATA/disk4/workspace/comfyui:/data \

nvcr.io/nvidia/cuda:12.8.1-cudnn-devel-ubuntu22.04 tail -f /dev/null

- 映射3001端口供访问comfyui的Web UI。

- 将一个宿主机的目录挂载到容器内的

/data目录,把comfyui代码和所需的模型都放在/data目录中,重建容器时可以复用数据。

下载模型

开始尝试把官方发布的模型文件直接放进ComfyUI中使用,折腾了几天都没有成功~~~。

后来发现,ComfyUI 使用的模型都是重新打包过的,例如:

- Hugging Face:Comfy-Org/Qwen-Image-Edit_ComfyUI

- ModelScope:Comfy-Org/flux1-dev

这些模型都是被ComfyUI重新打包(Repackaged)过的,通常情况下:

- 每个模型只有一个文件(官方发布的模型大多是把一个模型拆分为多个文件)。

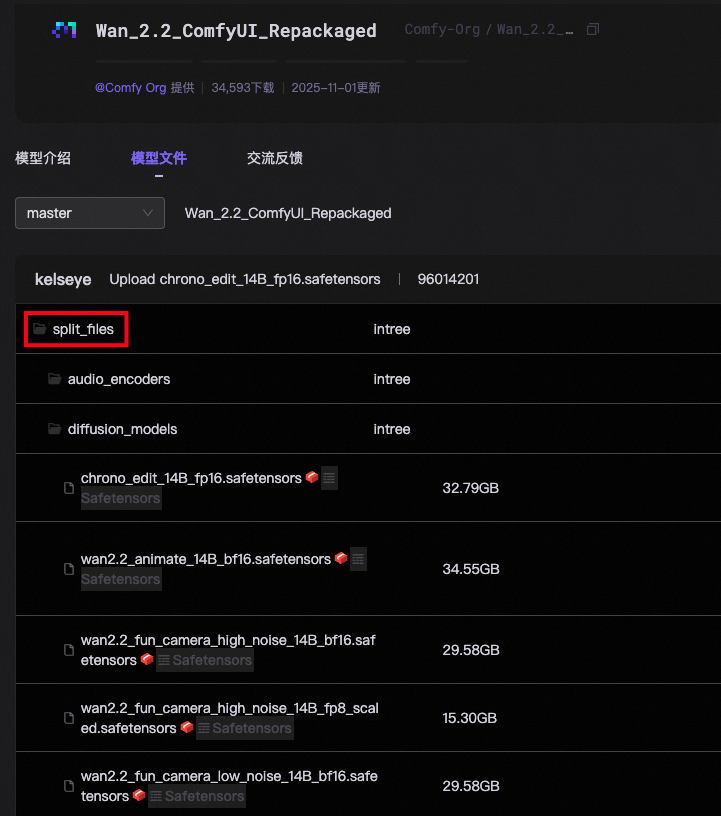

- 同一个模型的多个版本放置一个代码库中,例如:

经过repackaged的模型文件大多数都放置在split_files目录中,选择下载自己所需的模型就好,无需下载整个模型仓库,以ModelScope CLI为例,下载仓库中指定的单个模型文件:

modelscope download Comfy-Org/Qwen-Image-Edit_ComfyUI split_files/diffusion_models/qwen_image_edit_2509_bf16.safetensors --local_dir ./comfyui/

Wan2.2

ComfyUI官方示例

ComfyUI官方文档

[官方文档]中提供的workflow与[官方示例]中提供的不一样,[官方文档]中的工作流看上功能更多、更复杂。但[官方示例]中提供的workflow更容易上手。

ComfyUI不支持从ModelScope下载模型,如果在容器环境中设置了上网代理,可以在WebUI页面上直接下载模型,或者从WebUI页面上复制URL然后在命令行上用curl或者wget下载。在WebUI中选择一个template的后,会提示需要下载的模型列表。

安装

启动基础镜像后,运行docker exec -it comfyui bash进入容器环境后,按照这份文档中介绍的步骤安装即可。